最近はMax関係の記事が少なくって、iPhoneばかりとお嘆きかもしれませんが、当分この傾向は続くかも。もっとも、このサイトは個人サイトじゃないので、他の人も面白い話題があればお願いしますね(趣旨&景観に配慮して、公序良俗に反しない、ってことで)。

ただ、iPhoneを持っていないから関係ないって思うのは早計ね。あと何年もしないうちに、誰もがiPhone(あるいは同種のデバイス)用の作品を作ってますから。それは、数年前に多くの人がMax(あるいはプログラミング言語で)で音楽や映像を作るとは思っていなかったことと同じ。

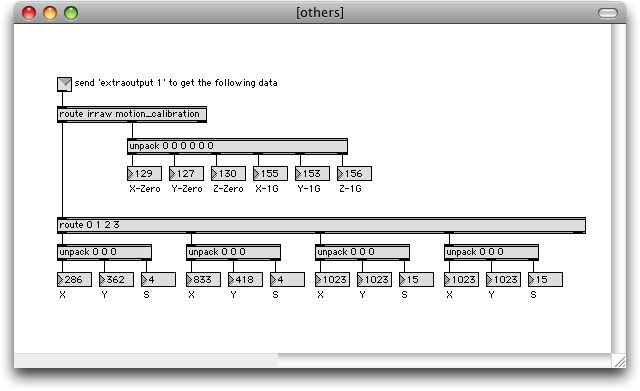

Maxに関しては、キブンはMax 5待ちで、特に基本環境的なことは今やる気になれません~。それに、少なくともランタイムがiPhoneに載らない限り、プロトタイピング以外にはMaxはiPhoneに縁がないです。もちろん、これまでもMaxは極めて優秀なプロトタイピング・ツールだったので、それはそれで正解ですけどね。私もMaxでアルゴリズムを作ってから、iPhoneのコードを書いてます。

それで、MaxのオブジェクトをC/C++で書いていた時も感じていたんだけど、テキスト記述型言語でプログラミングしている時は、頭が非常に活性化してハイな状態になる。それに対して、Maxでプログラミングをしている時は、頭は落ち着いていてロー(と言うかクワイエット)な状態になる。

これって、右脳/左脳、芸術野/計算野、鳥瞰的/虫瞰的って話なんだろうけど、なかなか面白いですね。Maxがアーティストに人気があるのは、メディア機能が強力なだけでなくって、そんなところに理由があるような気がするな。だから、ProcessingとかFlash(ActionScript)ってダメなんじゃない?

もっとも、右脳(芸術野)だけではアルゴリズムは作れない。これがアーティスト志望の人がプログラミングから脱落する最大の原因だと思う。なので、一般教養科目がほとんどないIAMASでも、数学(+英語)だけはあるし、DSPコースのワークショップでも半分はテキスト記述型言語(今年度はProcessingとPython)を使っている訳です。

誤解のないよう補足しておくと、左脳(計算野)だけでもアルゴリズムは作れませんよ。右脳と左脳の両方が必要です。そこで、Maxは両脳を明確に刺激するようになっていて、バランスが取れた状態(やや右脳寄り?)で物事を進める仕組みになっているような気がするな。それは後付けの見方かもしれないけど、Maxという存在自体がそのようになっているんだと思う。

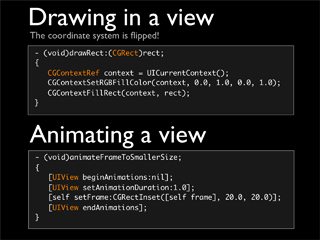

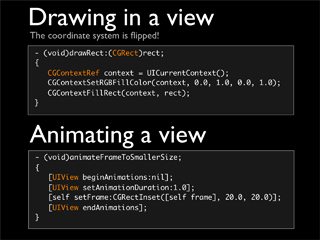

ちなみに、iPhone(と言うかOS X/Cocoa)の開発言語であるObjective-Cは、雰囲気的にMaxに近いです。Objective-CはCのスーパーセットなので、そんなことは本来ナイのですが、実際にプログラミングをしている時の頭の働きはMaxっぽい印象が強いですね。どちらもオブジェクト指向だからってこともあるし、いい加減にコードを書いても、それなりに動いてしまうところも似ています。

だから、次世代MaxはCocoaベースになって、Objective-Cでガンガンとオブジェクトを書けるようになって欲しいな。iPhoneでのランタイムあるいはフルセットも、Cocoaベースなら簡単に移植できるだろうしね。これ、強く希望!(と日本語で書いても、C74には伝わらない〜笑)。

で、タイトルの問いかけに戻って、Maxはプログラミング言語か?に対する答えは、Maxはプログラミング言語である!なのです。それも、芸術と計算が混じり合う極めて希有な存在(だから両方が必要)ですね。この特異性と有用性は、他の言語を使ってみると、よく分かります。そして、Objective-Cはこれに近くって、iPhone(と言うかOS X)という未来があるのだから、そろそろObjective-Cを始めてもいいんじゃない?という提案でもある訳です(やっぱり、ソコかぁ?と言われそうですが〜笑)。

![]()