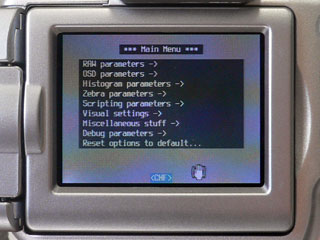

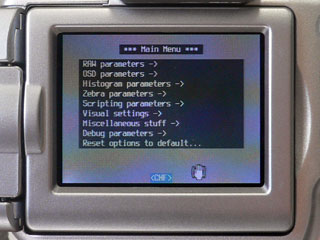

日本語Wikiもあるくらいだから、カメラ小僧的には有名なんだと思いますが、Canonのデジカメの機能を拡張しちゃう勝手ファームウェアCHDK(またはHDK)ってのがあります。本家はロシアらしいのですが、私は英語のWikiサイトの情報を元に試してみました。

私が持っているCanonのデジカメは、ちょいと古いPowerShot S2 ISで、これがバッチリ対応機種(ファームウェアはGM1.00F)でした。手順はFAQを順に追って行けば、数分で作業が完了します。カメラ本体のファームウェアを書き換えちゃうのではなく、電源を切れば元に戻るので、安心して試すことができます(でも自己責任ですよ〜)。毎回使うなら、電源投入時に自動起動するように設定すればラクチン。

それで、このCHDKで何が可能になるかと言うと、以下のようになかなか素晴らしいものがあります(CHDK In Briefより抄訳)。

主要な機能:

・RAWフォーマットでの画像保像

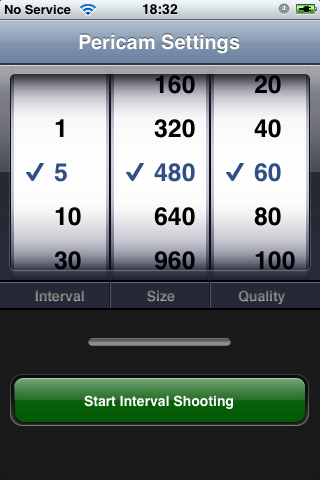

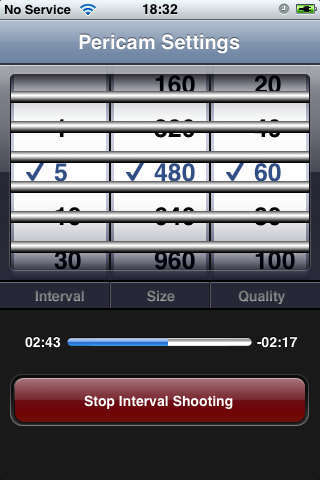

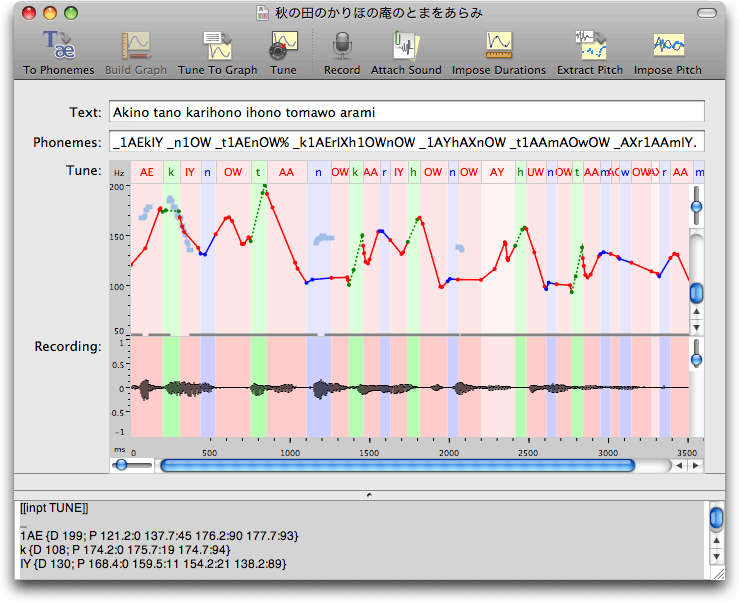

・スクリプトによる各種機能の自動実行

・ライブでのヒストグラム表示

・ゼブラ・モード(露光過不足領域の表示)

・詳細なバッテリー情報の常時表示

・自動暗領域減算の抑止

・圧縮率の高いビデオ・モード

・65秒までの長時間露光

・1/10,000秒までの短時間露光

・USBポートでのリモート・トリガー入力

追加の機能:

・被写界深度(FOD)の計算

・ファイル・ブラウザー

・テキスト・リーダー

・カレンダー

・その他のツールやゲーム

ゲームにはオセロと倉庫番があって、そこまでやるかぁ〜!?って感じですね。これらの他にも、さらに機能拡張されたビルドもあって、モーション(動体)検出やステレオ画像などもサポートされています。個人的には、BASIC言語のスクリプトやら極端な露出時間時間(理論的には1/100,000秒とか)、それにモーション検出ってあたりが冬休みの自由研究(笑)になりそうです。

さて、CHDKが露にした事柄によって、ハードウェア本来の性能を隠しているとメーカーの態度を非難することもできるけど、それはどこでも同じですよね。事情としては、機種ごとの差別化を図る販売戦略としての独善的な判断もあるし、使い勝手をまとめ上げるユーザービリティとしての苦渋の判断もあると思う。だけど、iPhoneもそうであるように、マニアックな裏口を知らん顔して開けておくってのは、企業裏戦略として重要なんじゃないかな。

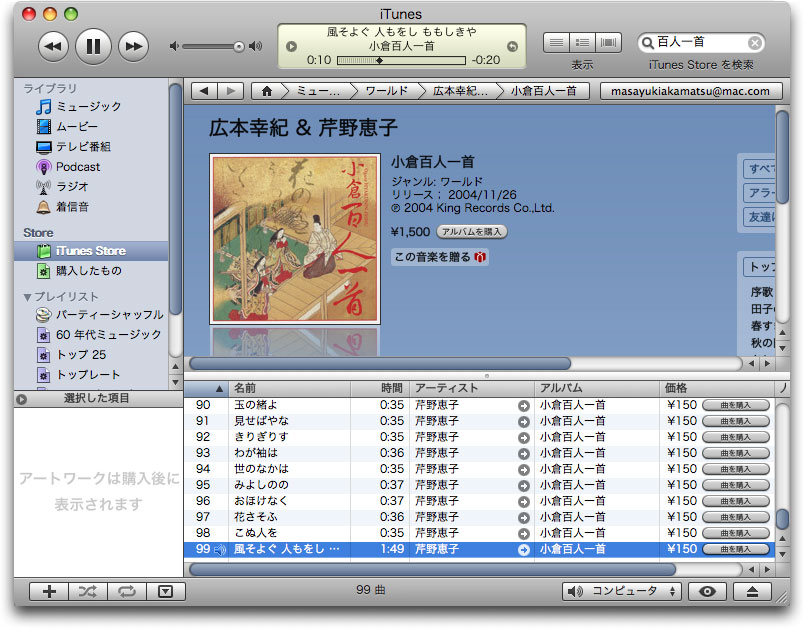

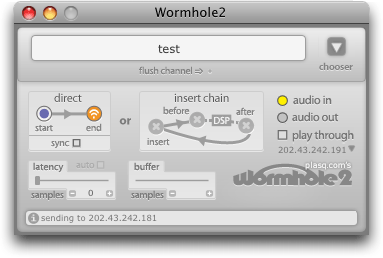

それから、いくつかのデジカメはUSBやFireWireやWi-Fi経由でコンピュータからコントロールできます(それがI2 ISを買った理由でした)。もちろん、Maxからもコントロールできるので、いろいろと発展できそうでしょ? この手のことにCanonは積極的だったような気がするけど、最近は対応状況(コンパクト・デジカメ、一眼レフ)を見る限り、縮小傾向にあるみたいで、ちょっと寂しい。